Категории:

ДомЗдоровьеЗоологияИнформатикаИскусствоИскусствоКомпьютерыКулинарияМаркетингМатематикаМедицинаМенеджментОбразованиеПедагогикаПитомцыПрограммированиеПроизводствоПромышленностьПсихологияРазноеРелигияСоциологияСпортСтатистикаТранспортФизикаФилософияФинансыХимияХоббиЭкологияЭкономикаЭлектроника

Предмет и задачи теории вероятностей и математической статистики.

Основные понятия теории вероятности. События и их виды.

Предмет и задачи теории вероятностей и математической статистики.

Теория вероятностей - раздел математики, в котором по данным вероятностям одних случайных событий находят вероятности других событий, связанных каким-либо образом с первыми. Теория вероятностей изучает также случайные величины и случайные процессы. Одна из основных задач теории вероятностей состоит в выяснении закономерностей, возникающих при взаимодействии большого числа случайных факторов (см. Больших чисел закон). Математический аппарат теории вероятностей используется при изучении массовых явлений в науке и технике. Методы теории вероятностей играют важную роль при обработке статистических данных.

Математическая статистика - наука о математических методах систематизации и использования статистических данных для научных и практических выводов. Во многих своих разделах математическая статистика опирается на теорию вероятностей, позволяющую оценить надежность и точность выводов, делаемых на основании ограниченного статистического материала (напр., оценить необходимый объем выборки для получения результатов требуемой точности при выборочном обследовании).

Предметом изучения теории вероятностей и математической статистики являются случайные события, величины и функции.

Определение. Событиемназывается всякий факт, который может произойти или не произойти в результате опыта.

При этом тот или иной результат опыта может быть получен с различной степенью возможности. Т.е. в некоторых случаях можно сказать, что одно событие произойдет практически наверняка, другое практически никогда.

В отношении друг друга события также имеют особенности, т.е. в одном случае событие А может произойти совместно с событием В, в другом – не может.

Определение. События называются несовместными, если появление одного из них исключает появление других.

Классическим примером несовместных событий является результат подбрасывания монеты – выпадение лицевой стороны монеты исключает выпадение обратной стороны (в одном и том же опыте).

Определение. Полной группой событий называется совокупность всех возможных результатов опыта.

Определение. Достоверным событиемназывается событие, которое наверняка произойдет в результате опыта. Событие называется невозможным, если оно никогда не произойдет в результате опыта.

Например, если из коробки, содержащей только красные и зеленые шары, наугад вынимают один шар, то появление среди вынутых шаров белого – невозможное событие. Появление красного и появление зеленого шаров образуют полную группу событий.

Определение. События называются равновозможными, если нет оснований считать, что одно из них появится в результате опыта с большей вероятностью.

В приведенном выше примере появление красного и зеленого шаров – равновозможные события, если в коробке находится одинаковое количество красных и зеленых шаров.

Если же в коробке красных шаров больше, чем зеленых, то появление зеленого шара – событие менее вероятное, чем появление красного.

Проводя несколько опытов, можно дать определение относительной частоты появления события.

Частота случайного события и «статистическое определение» вероятности.

Пусть А – случайное событие по отношению к некоторому испытанию. Представим себе, что это испытание произведено N раз и при этом событие А наступило в  случаях. Тогда отношение

случаях. Тогда отношение

называется частотой события А в данной серии испытаний.

Определение. Вероятностью случайного события А называется число  , около которого колеблется частота этого события в длинных сериях испытаний.

, около которого колеблется частота этого события в длинных сериях испытаний.

Пример 1.

Наблюдения показывают, что в среднем среди 1000 новорожденных детей 515 мальчиков. Частота рождения мальчика в такой серии наблюдений равна 0.515.

Пример 2.

Французский естествоиспытатель Бюффон (XVIII в.) бросил монету 4040 раз, и при этом герб выпал в 2048 случаях. Следовательно, частота выпадения герба в данной серии испытаний равна:

Пример 3.

Английский математик Карл Пирсон (1857-1936) бросал монету 24000 раз, причем герб выпал 12012 раз. Следовательно, частота выпадения герба в данной серии испытаний равна:

Примеры 2 и 3 подтверждают естественное предположение о том, что вероятность выпадения герба при одном бросании монеты равна 0.5.

Аксиомы теории вероятностей

При аксиоматическом подходе к изложению теории вероятностей за основу берется некоторое множество  , элементы

, элементы  которого называются элементарными событиями, а само

которого называются элементарными событиями, а само  - пространством элементарных событий.

- пространством элементарных событий.

Зафиксируем некоторую непустую систему S, состоящую из подмножества А, В, ... пространства элементарных событий. Подмножества А, В,... назовем событиями.

Относительно структуры системы S предположим выполненными следующие две аксиомы событий:

I. Если множества  ( в конечном или счетном числе) являются событиями, то их объединение

( в конечном или счетном числе) являются событиями, то их объединение  тоже является событием.

тоже является событием.

II. Если множество  является событием, то его дополнение

является событием, то его дополнение  до множества

до множества  тоже является событием.

тоже является событием.

Система S, удовлетворяющая аксиомам I и II, называется борелевским полем событий.

Из аксиом I и II вытекает, что  и если

и если  (i = 1, 2, …), то

(i = 1, 2, …), то  .

.

В дальнейшем операцию объединения событий будем называть сложением и обозначать знаком «+», операцию пересечения – умножением и обозначать знаком «-», а операцию <#40#>дополнения – переходом к противоположному событию<#41#> и выделять чертой сверху (например,  ). Кроме того, событие

). Кроме того, событие  назовем достоверным и обозначим U,

назовем достоверным и обозначим U,  - невозможным и обозначим V.

- невозможным и обозначим V.

В новых обозначениях аксиомы I и II запишутся:

I.

II. . События A и B назовем несовместными, если АВ = V (т.е.  ).

).

Аксиомы вероятностей:

1. Каждому событию A поставлено в соответствие неотрицательное число  , называемое вероятностью события A..

, называемое вероятностью события A..

2. Если события  попарно несовместны, то

попарно несовместны, то  (аксиома счетной аддитивности).

(аксиома счетной аддитивности).

3.  .

.

Совокупность трех объектов  , в которой S удовлетворяет аксиомам I и II, а функция

, в которой S удовлетворяет аксиомам I и II, а функция  – аксиомам 1, 2, 3, назовем вероятностной схемой.

– аксиомам 1, 2, 3, назовем вероятностной схемой.

|

СЛУЧАЙНЫЕ ВЕЛИЧИНЫ

Понятие случайной величины является основным в теории вероятностей и ее приложениях. Случайными величинами, например, являются число выпавших очков при однократном бросании игральной кости, число распавшихся атомов радия за данный промежуток времени, число вызовов на телефонной станции за некоторый промежуток времени, отклонение от номинала некоторого размера детали при правильно налаженном технологическом процессе и т. д.

Таким образом, случайной величиной называется переменная величина, которая в результате опыта может принимать то или иное числовое значение.

В дальнейшем мы рассмотрим два типа случайных величин — дискретные и непрерывные.

Дискретные случайные величины.

Рассмотрим случайную величину *  , возможные значения которой образуют конечную или бесконечную последовательность чисел x1, x2, ..., xn, ... . Пусть задана функция p(x), значение которой в каждой точке x=xi (i=1,2, ...) равно вероятности того, что величина

, возможные значения которой образуют конечную или бесконечную последовательность чисел x1, x2, ..., xn, ... . Пусть задана функция p(x), значение которой в каждой точке x=xi (i=1,2, ...) равно вероятности того, что величина  примет значение xi

примет значение xi

| (16) |

Такая случайная величина  называется дискретной (прерывной). Функция р(х) называется законом распределения вероятностей случайной величины, или кратко, законом распределения. Эта функция определена в точках последовательности x1, x2, ..., xn, ... . Так как в каждом из испытаний случайная величина

называется дискретной (прерывной). Функция р(х) называется законом распределения вероятностей случайной величины, или кратко, законом распределения. Эта функция определена в точках последовательности x1, x2, ..., xn, ... . Так как в каждом из испытаний случайная величина  принимает всегда какое-либо значение из области ее изменения, то

принимает всегда какое-либо значение из области ее изменения, то

Пример 2. Пусть случайная величина  - число наступления события A при одном испытании, причем P(A)=p. Множество возможных значений

- число наступления события A при одном испытании, причем P(A)=p. Множество возможных значений  состоит из 2-х чисел 0 и 1:

состоит из 2-х чисел 0 и 1:  =0, если событие A не произошло, и

=0, если событие A не произошло, и  =1, если событие A произошло. Таким образом,

=1, если событие A произошло. Таким образом,

Предположим, что производится n независимых испытаний, в результате каждого из которых может наступить или не наступить событие A. Пусть вероятность наступления события A при каждом испытании равна p. Рассмотрим случайную величину  — число наступлений события A при n независимых испытаниях. Область изменения

— число наступлений события A при n независимых испытаниях. Область изменения  состоит из всех целых чисел от 0 до n включительно. Закон распределения вероятностей р(m) определяется формулой Бернулли (13'):

состоит из всех целых чисел от 0 до n включительно. Закон распределения вероятностей р(m) определяется формулой Бернулли (13'):

Закон распределения вероятностей по формуле Бернулли часто называют биномиальным, так как Pn(m) представляет собой m-й член разложения бинома  .

.

Пусть случайная величина  может принимать любое целое неотрицательное значение, причем

может принимать любое целое неотрицательное значение, причем

| (17) |

где  — некоторая положительная постоянная. В этом случае говорят, что случайная величина

— некоторая положительная постоянная. В этом случае говорят, что случайная величина  распределена по закону Пуассона, Заметим, что при k=0 следует положить 0!=1.

распределена по закону Пуассона, Заметим, что при k=0 следует положить 0!=1.

Как мы знаем, при больших значениях числа n независимых испытаний вероятность Pn(m) наступления m раз события A удобнее находить не по формуле Бернулли, а по формуле Лапласа [см. формулу (15)  ].

].

Однако последняя дает большие погрешности при малой вероятности р появления события А в одном испытании. В этом случае для подсчета вероятности Pn(m) удобно пользоваться формулой Пуассона, в которой следует положить  .

.

Формулу Пуассона можно получить как предельный случай формулы Бернулли при неограниченном увеличении числа испытаний n и при стремлении к нулю вероятности  .

.

Распределение Пуассона часто встречается и в других задачах. Так, например, если телефонистка в среднем за один час получает N вызовов, то, как можно показать, вероятность Р(k) того, что в течение одной минуты она получит k вызовов, выражается формулой Пуассона, если положить  .

.

Если возможные значения случайной величины  образуют конечную последовательность x1, x2, ..., xn, то закон распределения вероятностей случайной величины задают в виде следующей таблицы, в которой

образуют конечную последовательность x1, x2, ..., xn, то закон распределения вероятностей случайной величины задают в виде следующей таблицы, в которой

и

Значения

| x1 | x2 | ... | xn |

| Вероятности p(xi) | p1 | p2 | ... | pn |

Эту таблицу называют рядом распределения случайной величины  . Наглядно функцию р(х) можно изобразить в виде графика. Для этого возьмем прямоугольную систему координат на плоскости.

. Наглядно функцию р(х) можно изобразить в виде графика. Для этого возьмем прямоугольную систему координат на плоскости.

По горизонтальной оси будем откладывать возможные значения случайной величины  , а по вертикальной оси - значения функции

, а по вертикальной оси - значения функции  . График функции р(х) изображен на рис. 2. Если соединить точки этого графика прямолинейными отрезками, то получится фигура, которая называется многоугольником распределения.

. График функции р(х) изображен на рис. 2. Если соединить точки этого графика прямолинейными отрезками, то получится фигура, которая называется многоугольником распределения.

Пример 4. Пусть событие А — появление одного очка при бросании игральной кости; Р(A)=1/6. Рассмотрим случайную величину  — число наступлений события А при десяти бросаниях игральной кости. Значения функции р(х) (закона распределения) приведены в следующей таблице:

— число наступлений события А при десяти бросаниях игральной кости. Значения функции р(х) (закона распределения) приведены в следующей таблице:

Значения

| |||||||||||

| Вероятности p(xi) | 0,162 | 0,323 | 0,291 | 0,155 | 0,054 | 0,013 | 0,002 |

Вероятности p(xi) вычислены по формуле Бернулли при n=10. Для x>6 они практически равны нулю. График функции p(x) изображен на рис. 3.

Упражнение 3.2

Показать, что у функции распределения  в каждой точке существует предел слева, т.е. существует

в каждой точке существует предел слева, т.е. существует

Упражнение 3.3 Показать, что множество точек разрыва функции  не более, чем счетно. (Точка разрыва:

не более, чем счетно. (Точка разрыва:  .)

.)

Пример 3.1 Простейший случай -- константа:  . В этом случае

. В этом случае

Пример 3.2

Дискретная случайная величина  -- число выпавших очков на игральной кости:

-- число выпавших очков на игральной кости:

Пример 3.3

Более общая дискретная случайная величина

| со значениями |

|

|

|

|

|

|  , ,

| принимаемыми |

| с вероятностями |

| , |

| , |

| , |

| соответственно. |

Замечание 3.4 Каков вероятностный смысл точки разрыва функции распределения ? Ответ на этот вопрос получится, если в (16) положить  , а

, а  устремить к

устремить к  слева:

слева:

(Чтобы строго обосновать этот вывод, следует воспользоваться свойствами вероятностной меры из  3.1.) Таким образом, функция распределения имеет разрыв в точке

3.1.) Таким образом, функция распределения имеет разрыв в точке  тогда и только тогда, когда

тогда и только тогда, когда  . Более того, величина скачка в точке разрыва совпадает с этой вероятностью.

. Более того, величина скачка в точке разрыва совпадает с этой вероятностью.

10 Функция распределения случайной величины. Её свойства

Каждая случайная величина полностью определяется своей функцией распределения.

Если .- случайная величина, то функция F(x) = F (x) = P( < x) называется функцией распределения случайной величины . Здесь P( < x) - вероятность того, что случайная величина принимает значение, меньшее x.

Важно понимать, что функция распределения является “паспортом” случайной величины: она содержит всю информация о случайной величине и поэтому изучение случайной величины заключается в исследовании ее функции распределения, которую часто называют простораспределением.

Функция распределения любой случайной величины обладает следующими свойствами:

· F(x)определена на всей числовой прямой R;

· F(x)не убывает, т.е. если x1  x2, то F(x1)

x2, то F(x1)  F(x2);

F(x2);

· F(-  )=0, F(+

)=0, F(+  )=1,т.е.

)=1,т.е.  и

и  ;

;

· F(x) непрерывна справа, т.е.

11.Плотностью распределения (или плотностью вероятности) непрерывной случайной величины X в точке x называется производная ее функции распределения в этой точке и обозначается f(x). График плотности распределения называется кривой распределения.

Пусть имеется точка x и прилегающий к ней отрезок dx. Вероятность попадания случайной величиныX на этот интервал равна f(x)dx. Эта величина называется элементом вероятности.

Вероятность попадания случайной величины X на произвольный участок [a, b[ равна сумме элементарных вероятностей на этом участке:

(5.7)

(5.7)

В геометрической интерпретации P{α≤X<β} равна площади, ограниченной сверху кривой плотности распределения f(x) и опирающейся на участок (α,β) (рис. 5.4).

Это соотношение позволяет выразить функцию распределения F(x) случайной величины X через ее плотность:

(5.8)

(5.8)

В геометрической интерпретации F(x) равна площади, ограниченной сверху кривой плотности распределения f(x) и лежащей левее точки x (рис. 5.5).

Основные свойства плотности распределения:

1. Плотность распределения неотрицательна: f(x) ³ 0.

Это свойство следует из определения f(x) – производная неубывающей функции не может быть отрицательной.

2. Условие нормировки:  Это свойство следует из формулы (5.8), если положить в нейx=∞.

Это свойство следует из формулы (5.8), если положить в нейx=∞.

Геометрически основные свойства плотности f(x) интерпретируются так:

1. вся кривая распределения лежит не ниже оси абсцисс;

2. полная площадь, ограниченная кривой распределения и осью абсцисс, равна единице.

Свойства дисперсии

Дисперсия постоянной величины с равна нулю.

Доказательство: по определению дисперсии

При прибавлении к случайной величине Х неслучайной величины с ее дисперсия не меняется.

D[X+c] = D[X].

Доказательство: по определению дисперсии

(6.12)

(6.12)

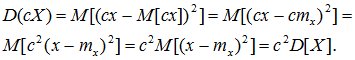

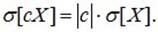

3. При умножении случайной величины Х на неслучайную величину с ее дисперсия умножается на с2.

Доказательство: по определению дисперсии

. (6.13)

. (6.13)

Для среднего квадратичного отклонения это свойство имеет вид:

(6.14)

(6.14)

Действительно, при ½С½>1 величина сХ имеет возможные значения (по абсолютной величине), большие, чем величина Х. Следовательно, эти значения рассеяны вокруг математического ожиданияМ[сХ] больше, чем возможные значения Х вокруг М[X], т.е.  . Если 0<½с½<1, то

. Если 0<½с½<1, то  .

.

Правило 3s. Для большинства значений случайной величины абсолютная величина ее отклонения от математического ожидания не превосходит утроенного среднего квадратического отклонения, или, другими словами, практически все значения СВ находятся в интервале:

[ m - 3s; m + 3s; ].(6.15)

Характеристики

В следующей таблице приведены формулы для вычисления характеристик распределения Пуассона с параметром a.

| Функция вероятности |  , ,

|

| Функция распределения |  , ,

|

| Математическое ожидание | a |

| Дисперсия | a |

Моделирование

Моделирование значений пуассоновской случайной величины с параметром a основано на предельной теореме, согласно которой распределение биномиальной случайной величины Bn,p при больших n и малых p хорошо аппроксимирует распределение Пуассона с параметром a = np. Поэтому достаточно выбрать большое значение n, вычислить p = a / n, и моделировать Bn,p.

17.

3. Показательное распределение.

3.1. Интегральная и дифференциальная функции распределения.

Определение: Непрерывная случайная величина X, функция плотности которой задается выражением

Определение: Непрерывная случайная величина X, функция плотности которой задается выражением

называется случайной величиной, имеющей показательное, или экспоненциальное, распределение.

Величина срока службы различных устройств и времени безотказной работы отдельных элементов этих устройств при выполнении определенных условий обычно подчиняется показательному распределению. Другими словами, величина промежутка времени между появлениями двух последовательных редких событий подчиняется зачастую показательному распределению.

Как видно из формулы , показательное распределение определяется только одним параметром .

Найдем функцию распределения показательного закона, используя свойства дифференциальной функции распределения:

Графики дифференциальной и интегральной функций показательного распределения имеют вид:

18. Нормальный закон распределения.

Правило трех сигм

Преобразуем формулу

Введем обозначение

Тогда получим:

Если t=3, то

т. е. вероятность того, что отклонение по абсолютной величине будет меньше утроенного среднего квадратического отклонения, равна 0,9973.

Другими словами, вероятность того, что абсолютная величина отклонения превысит утроенное среднее квадратическое отклонение, очень мала, а именно равна 0,0027=1-0,9973. Это означает, что лишь в 0,27% случаев так может произойти. Такие события, исходя из принципа невозможности маловероятных событий можно считать практически невозможными. В этом и состоит сущность правила трех сигм:

Если случайная величина распределена нормально, то абсолютная величина ее отклонения от математического ожидания не превосходит утроенного среднего квадратического отклонения.

Если случайная величина распределена нормально, то абсолютная величина ее отклонения от математического ожидания не превосходит утроенного среднего квадратического отклонения.

На практике правило трех сигм применяют так: если распределение изучаемой случайной величины неизвестно, но условие, указанное в приведенном правиле, выполняется, то есть основание предполагать, что изучаемая величина распределена нормально; в противном случае она не распределена нормально.

Функция Лапласа

Найдем вероятность попадания случайной величины, распределенной по нормальному закону, в заданный интервал.

Обозначим

Тогда

Т.к. интеграл не выражается через элементарные функции, то вводится в рассмотрение функция

которая называется функцией Лапласа или интегралом вероятностей.

Значения этой функции при различных значениях х посчитаны и приводятся в специальных таблицах.

Ниже показан график функции Лапласа.

Функция Лапласа обладает следующими свойствами:

1) Ф(0) = 0;

2) Ф(-х) = - Ф(х);

3) Ф(¥) = 1.

Функцию Лапласа также называют функцией ошибок и обозначают erf x.

Еще используется нормированная функция Лапласа, которая связана с функцией Лапласа соотношением:

Ниже показан график нормированной функции Лапласа.

Система случайных величин

Рассмотренные выше случайные величины были одномерными, т.е. определялись одним числом, однако, существуют также случайные величины, которые определяются двумя, тремя и т.д. числами. Такие случайные величины называются двумерными, трехмерными и т.д.

В зависимости от типа, входящих в систему случайных величин, системы могут быть дискретными, непрерывными или смешанными, если в систему входят различные типы случайных величин.

Более подробно рассмотрим системы двух случайных величин.

Определение. Законом распределения системы случайных величин называется соотношение, устанавливающее связь между областями возможных значений системы случайных величин и вероятностями появления системы в этих областях.

Определение. Функцией распределения системы двух случайных величин называется функция двух аргументов F(x, y), равная вероятности совместного выполнения двух неравенств X<x, Y<y.

Отметим следующие свойства функции распределения системы двух случайных величин:

1) Если один из аргументов стремится к плюс бесконечности, то функция распределения системы стремится к функции распределения одной случайной величины, соответствующей другому аргументу.

2) Если оба аргумента стремятся к бесконечности, то функция распределения системы стремится к единице.

3) При стремлении одного или обоих аргументов к минус бесконечности функция распределения стремится к нулю.

4) Функция распределения является неубывающей функцией по каждому аргументу.

5) Вероятность попадания случайной точки (X, Y) в произвольный прямоугольник со сторонами, параллельными координатным осям, вычисляется по формуле.

Закон больших чисел

Теоретическим обоснованием этого замечательного свойства случайных явлений является закон больших чисел. Названием "закон больших чисел" объединена группа теорем, устанавливающих устойчивость средних результатов большого количества случайных явлений и объясняющих причину этой устойчивости.

Простейшая форма закона больших чисел, и исторически первая теорема этого раздела -теорема Бернулли, утверждающая, что если вероятность события одинакова во всех испытаниях, то с увеличением числа испытаний частота события стремится к вероятности события и перестает быть случайной.

Теорема Пуассона утверждает, что частота события в серии независимых испытаний стремится к среднему арифметическому его вероятностей и перестает быть случайной.

Предельные теоремы теории вероятностей, теоремы Муавра-Лапласа объясняют природу устойчивости частоты появлений события. Природа эта состоит в том, что предельным распределением числа появлений события при неограниченном возрастании числа испытаний (если вероятность события во всех испытаниях одинакова) является нормальное распределение.

Центральная предельная теорема объясняет широкое распространение нормального закона распределения. Теорема утверждает, что всегда, когда случайная величина образуется в результате сложения большого числа независимых случайных величин с конечными дисперсиями, закон распределения этой случайной величины оказывается практически нормальным законом.

Теорема, приведенная ниже под названием "Закон больших чисел" утверждает, что при определенных, достаточно общих, условиях, с увеличением числа случайных величин их среднее арифметическое стремится к среднему арифметическому математических ожиданий и перестает быть случайным.

Теорема Ляпунова объясняет широкое распространение нормального закона распределения и поясняет механизм его образования. Теорема позволяет утверждать, что всегда, когда случайная величина образуется в резул

Последнее изменение этой страницы: 2016-08-11

lectmania.ru. Все права принадлежат авторам данных материалов. В случае нарушения авторского права напишите нам сюда...

Действительно,

Действительно,

Следовательно,

Следовательно,

Отсюда

Отсюда

т. е. события А и В независимы. Независимость событий

т. е. события А и В независимы. Независимость событий

является следствием доказанного утверждения.

Несколько событий называют попарно независимыми, если каждые два из них независимы. Например, события А, В, С попарно независимы, если независимы события А и В, А и С, В и С.

Для того чтобы обобщить теорему умножения на несколько событий, введем понятие независимости событий в совокупности.

Несколько событий называют независимыми в совокупности (или просто независимыми), если независимы каждые два из них и независимы каждое событие и все возможные произведения остальных. Например, если события A1, A2, А3, независимы в совокупности, то независимы события A1 и А2, А1 и А3, А2 и A3; А1 и A2A3, A2 и A1A3, А3 и A1A2. Из сказанного следует, что если события независимы в совокупности, то условная вероятность появления любого события из них, вычисленная в предположении, что наступили какие-либо другие события из числа остальных, равна его безусловной вероятности.

Подчеркнем, что если несколько событий независимы попарно, то отсюда еще не следует их независимость в совокупности. В этом смысле требование независимости событий в совокупности сильнее требования их попарной независимости.

Поясним сказанное на примере. Пусть в урне имеется 4 шара, окрашенные: один — в красный цвет (А), один — в синий цвет (В), один — в черный цвет (С) и один — во все эти три цвета (АВС). Чему равна вероятность того, что извлеченный из урны шар имеет красный цвет?

Так как из четырех шаров два имеют красный цвет, то Р(А) = 2 / 4 = 1 / 2. Рассуждая аналогично, найдем Р (В) = 1 / 2, Р (С) = 1/ 2. Допустим теперь, что взятый шар имеет синий цвет, т. е. событие В уже произошло. Изменится ли вероятность того, что извлеченный шар имеет красный цвет, т. е. изменится ли вероятность события А? Из двух шаров, имеющих синий цвет, один шар имеет и красный цвет, поэтому вероятность события А по-прежнему равна 1 / 2. Другими словами, условная вероятность события А, вычисленная в предположении, что наступило событие В, равна его безусловной вероятности. Следовательно, события А и В независимы. Аналогично придем к выводу, что события A и С, В и С независимы. Итак, события А, В и С попарно независимы.

Независимы ли эти события в совокупности? Оказывается, нет. Действительно, пусть извлеченный шар имеет два цвета, например синий и черный. Чему равна вероятность того, что этот шар имеет и красный цвет? Лишь один шар окрашен во все три цвета, поэтому взятый шар имеет и красный цвет. Таким образом, допустив, что события В и С произошли, приходим к выводу, что событие А обязательно наступит. Следовательно, это событие достоверное и вероятность его равна единице. Другими словами, условная вероятность РBC (A)= 1 события А не равна его безусловной вероятности Р (А) = 1 / 2. Итак, попарно независимые события А, В, С не являются независимыми в совокупности.

Приведем теперь следствие из теоремы умножения.

С л е д с т в и е. Вероятность совместного появления нескольких событий, независимых в совокупности, равна произведению вероятностей этих событий:

Р (А1А2 ... Аn) = Р (А1) Р (А2) ... Р (Аn).

Доказательство

З а м е ч а н и е. Если события А1, А2, ..., Аn независимы в совокупности, то и противоположные им события

является следствием доказанного утверждения.

Несколько событий называют попарно независимыми, если каждые два из них независимы. Например, события А, В, С попарно независимы, если независимы события А и В, А и С, В и С.

Для того чтобы обобщить теорему умножения на несколько событий, введем понятие независимости событий в совокупности.

Несколько событий называют независимыми в совокупности (или просто независимыми), если независимы каждые два из них и независимы каждое событие и все возможные произведения остальных. Например, если события A1, A2, А3, независимы в совокупности, то независимы события A1 и А2, А1 и А3, А2 и A3; А1 и A2A3, A2 и A1A3, А3 и A1A2. Из сказанного следует, что если события независимы в совокупности, то условная вероятность появления любого события из них, вычисленная в предположении, что наступили какие-либо другие события из числа остальных, равна его безусловной вероятности.

Подчеркнем, что если несколько событий независимы попарно, то отсюда еще не следует их независимость в совокупности. В этом смысле требование независимости событий в совокупности сильнее требования их попарной независимости.

Поясним сказанное на примере. Пусть в урне имеется 4 шара, окрашенные: один — в красный цвет (А), один — в синий цвет (В), один — в черный цвет (С) и один — во все эти три цвета (АВС). Чему равна вероятность того, что извлеченный из урны шар имеет красный цвет?

Так как из четырех шаров два имеют красный цвет, то Р(А) = 2 / 4 = 1 / 2. Рассуждая аналогично, найдем Р (В) = 1 / 2, Р (С) = 1/ 2. Допустим теперь, что взятый шар имеет синий цвет, т. е. событие В уже произошло. Изменится ли вероятность того, что извлеченный шар имеет красный цвет, т. е. изменится ли вероятность события А? Из двух шаров, имеющих синий цвет, один шар имеет и красный цвет, поэтому вероятность события А по-прежнему равна 1 / 2. Другими словами, условная вероятность события А, вычисленная в предположении, что наступило событие В, равна его безусловной вероятности. Следовательно, события А и В независимы. Аналогично придем к выводу, что события A и С, В и С независимы. Итак, события А, В и С попарно независимы.

Независимы ли эти события в совокупности? Оказывается, нет. Действительно, пусть извлеченный шар имеет два цвета, например синий и черный. Чему равна вероятность того, что этот шар имеет и красный цвет? Лишь один шар окрашен во все три цвета, поэтому взятый шар имеет и красный цвет. Таким образом, допустив, что события В и С произошли, приходим к выводу, что событие А обязательно наступит. Следовательно, это событие достоверное и вероятность его равна единице. Другими словами, условная вероятность РBC (A)= 1 события А не равна его безусловной вероятности Р (А) = 1 / 2. Итак, попарно независимые события А, В, С не являются независимыми в совокупности.

Приведем теперь следствие из теоремы умножения.

С л е д с т в и е. Вероятность совместного появления нескольких событий, независимых в совокупности, равна произведению вероятностей этих событий:

Р (А1А2 ... Аn) = Р (А1) Р (А2) ... Р (Аn).

Доказательство

З а м е ч а н и е. Если события А1, А2, ..., Аn независимы в совокупности, то и противоположные им события

также независимы в совокупности.

также независимы в совокупности.